負責任地使用生成式 AI

點擊上方圖片觀看本課程的影片

很容易對 AI 尤其是生成式 AI 感到著迷,但你需要考慮如何負責任地使用它。你需要考慮如何確保輸出是公平的、無害的等等。本章旨在為你提供提到的背景、需要考慮的事項以及如何採取積極措施來改進你的 AI 使用。

簡介

本課程將涵蓋:

- 為什麼在建構生成式 AI 應用程式時應優先考慮負責任的 AI。

- 負責任的 AI 的核心原則及其與生成式 AI 的關係。

- 如何通過策略和工具將這些負責任的 AI 原則付諸實踐。

學習目標

完成本課程後,您將會知道:

- 建構生成式 AI 應用程式時負責任 AI 的重要性。

- 何時在建構生成式 AI 應用程式時思考並應用負責任 AI 的核心原則。

- 有哪些工具和策略可以幫助你將負責任 AI 的概念付諸實踐。

負責任的 AI 原則

Generative AI 的興奮程度從未如此之高。這種興奮吸引了許多新開發者、關注和資金進入這個領域。雖然這對於任何希望使用 Generative AI 建構產品和公司的人士來說是非常積極的,但我們也必須負責任地前進。

在整個課程中,我們專注於建構我們的初創公司和我們的 AI 教育產品。我們將使用負責任 AI 的原則: 公平性、包容性、可靠性/安全性、安全性和隱私、透明性和問責制。通過這些原則,我們將探索它們如何與我們在產品中使用生成式 AI 相關。

為什麼你應該優先考慮負責任的 AI

在建構產品時,採取以人為本的方法,並考慮使用者的最佳利益,會帶來最佳結果。

生成式 AI 的獨特之處在於其為用戶創建有用答案、資訊、指導和內容的能力。這可以在不需要許多手動步驟的情況下完成,從而產生非常令人印象深刻的結果。然而,若沒有適當的規劃和策略,這也可能不幸地為您的用戶、產品和整個社會帶來一些有害的結果。

讓我們來看看這些潛在有害結果中的一些(但不是全部):

幻覺

幻覺是一個術語,用來描述當LLM產生的內容完全沒有意義或根據其他來源的資訊我們知道是事實錯誤的情況。

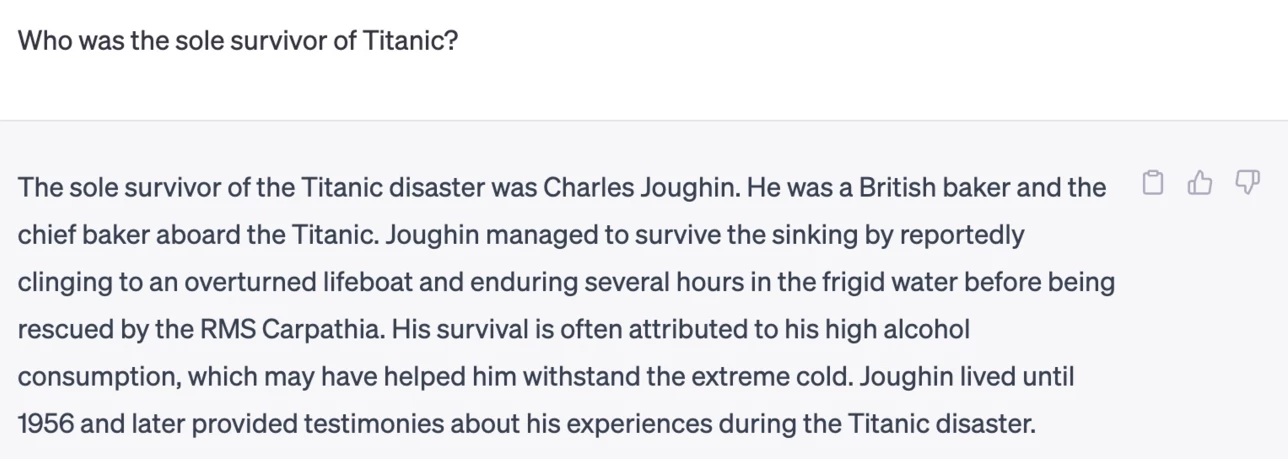

讓我們以建構一個功能為例,該功能允許學生向模型提問歷史問題。一位學生問了這個問題 誰是泰坦尼克號的唯一倖存者?

模型產生的回應如下:

(來源: Flying bisons)

這是一個非常自信且徹底的回答。不幸的是,它是錯誤的。即使只做了最少量的研究,也會發現泰坦尼克號災難中有不止一個倖存者。對於剛開始研究這個主題的學生來說,這個答案可能足夠有說服力而不被質疑並被視為事實。這樣的後果可能導致 AI 系統不可靠,並對我們初創公司的聲譽產生負面影響。

隨著每次任意LLM的迭代,我們已經看到在最小化幻覺方面的性能改進。即使有了這些改進,我們作為應用程式建構者和使用者仍然需要意識到這些限制。

有害內容

我們在前一節中討論了當 LLM 產生不正確或無意義的回應時的情況。我們需要注意的另一個風險是當模型回應有害內容時。

有害內容可以定義為:

- 提供自我傷害或傷害特定群體的指示或鼓勵。

- 仇恨或貶低的內容。

- 指導計劃任何類型的攻擊或暴力行為。

- 提供如何查找非法內容或進行非法行為的指示。

- 顯示露骨的性內容。

為了我們的初創公司,我們希望確保我們擁有正確的工具和策略,以防止學生看到此類內容。

缺乏公平性

公平被定義為「確保 AI 系統沒有偏見和歧視,並且公平和平等地對待每個人」。在生成式 AI 的世界中,我們希望確保模型的輸出不會強化邊緣化群體的排他性世界觀。

這些類型的輸出不僅對建構正面的產品體驗有破壞性,還會對社會造成進一步的傷害。作為應用程式建構者,我們在使用生成式 AI 建構解決方案時,應該始終考慮到廣泛且多樣化的使用者群體。

如何負責任地使用生成式 AI

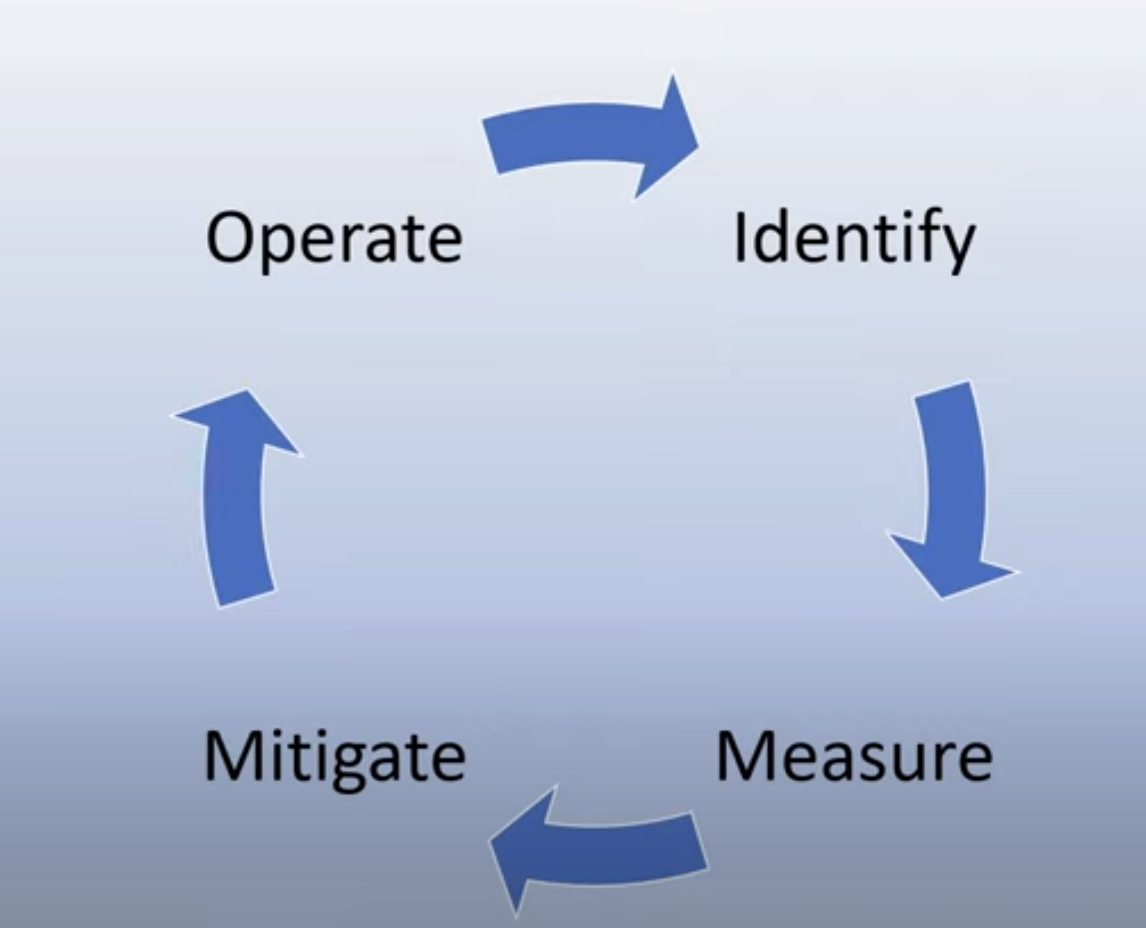

現在我們已經確定了負責任生成式 AI 的重要性,讓我們來看看可以採取的 4 個步驟,以負責任地建構我們的 AI 解決方案:

測量潛在危害

在軟體測試中,我們測試使用者在應用程式上的預期操作。同樣地,測試使用者最有可能使用的各種提示是一種衡量潛在危害的好方法。

由於我們的初創公司正在建構一款教育產品,準備一份與教育相關的提示清單會很有幫助。這可以涵蓋某個特定主題、歷史事實以及關於學生生活的提示。

減輕潛在危害

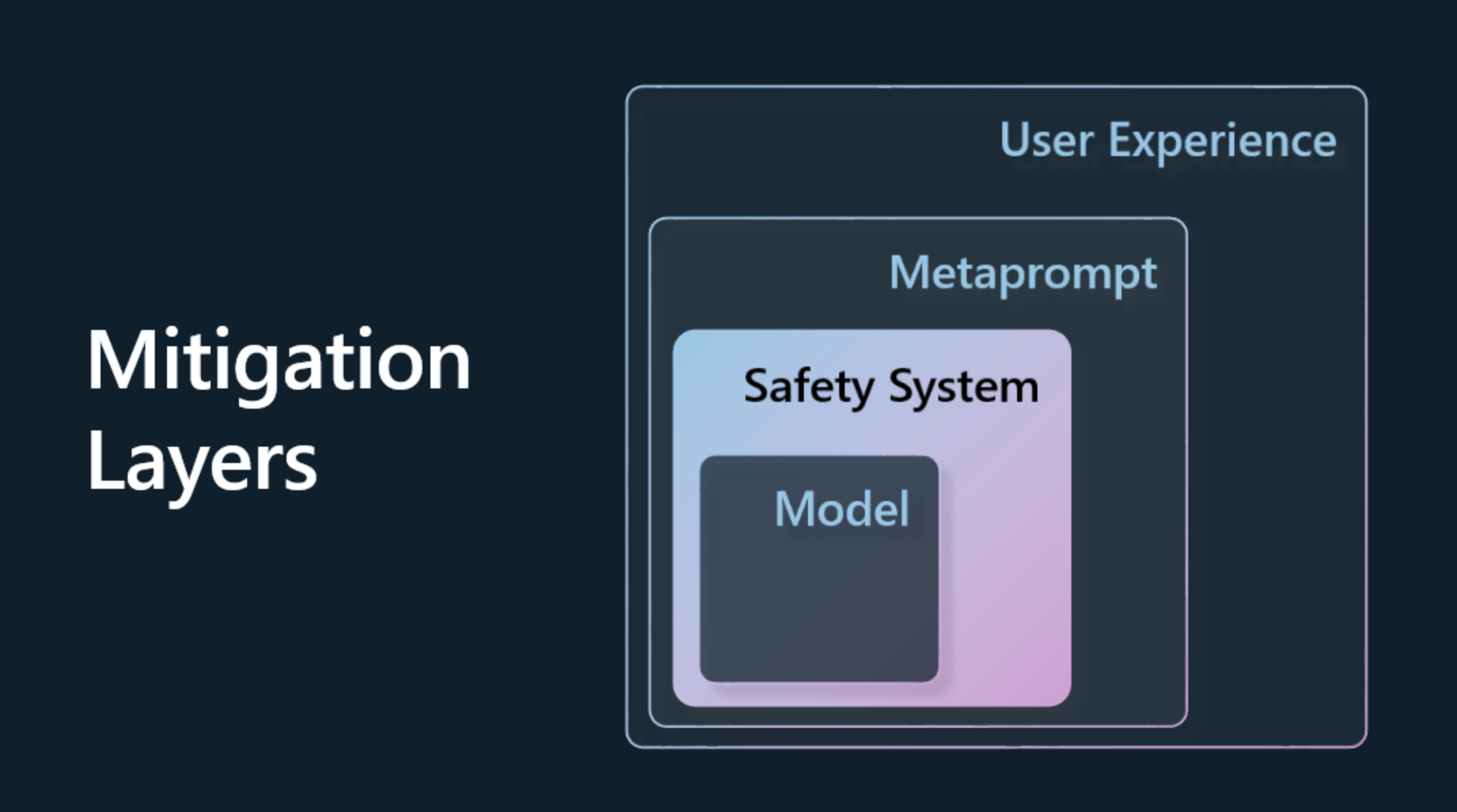

現在是時候找出方法來防止或限制模型及其回應可能造成的潛在傷害。我們可以從4個不同層面來看這個問題:

-

模型. 為正確的使用案例選擇正確的模型。像 GPT-4 這樣更大且更複雜的模型在應用於較小且更具體的使用案例時,可能會帶來更多有害內容的風險。使用您的訓練數據進行微調也可以減少有害內容的風險。

-

安全系統. 安全系統是一組在平台上服務模型的工具和配置,有助於減輕危害。範例是 Azure OpenAI 服務上的內容過濾系統。系統還應該檢測越獄攻擊和不需要的活動,例如來自機器人的請求。

-

Metaprompt. Metaprompt 和基礎是我們可以根據某些行為和資訊來指導或限制模型的方法。這可以使用系統輸入來定義模型的某些限制。此外,提供更相關於系統範圍或領域的輸出。

它也可以使用像檢索增強生成(RAG)這樣的技術,讓模型僅從選定的可信來源中提取資訊。本課程後面有一節是建構搜尋應用程式。

- 使用者體驗。最終層是使用者通過我們應用程式的介面以某種方式直接與模型互動。在這種方式下,我們可以設計 UI/UX 來限制使用者能夠傳送給模型的輸入類型以及顯示給使用者的文字或圖像。在部署 AI 應用程式時,我們也必須透明地告知我們的生成式 AI 應用程式能夠和不能夠做的事情。

我們有一整節課專門介紹設計 AI 應用的 UX

- 評估模型. 使用 LLMs 可能具有挑戰性,因為我們無法總是控制模型訓練所使用的數據。不管怎樣,我們應該始終評估模型的性能和輸出。衡量模型的準確性、相似性、基礎性和輸出的相關性仍然很重要。這有助於為利益相關者和用戶提供透明度和信任。

操作負責任的生成式 AI 解決方案

建構圍繞您的 AI 應用程式的操作實踐是最後階段。這包括與我們初創公司中的其他部門(如法務和安全)合作,以確保我們符合所有監管政策。在推出之前,我們還希望制定有關交付、處理事件和回滾的計劃,以防止用戶因增長而受到任何損害。

工具

雖然開發負責任的 AI 解決方案的工作可能看起來很多,但這些工作非常值得努力。隨著生成式 AI 領域的增長,更多幫助開發者有效地將責任整合到他們工作流程中的工具將會成熟。例如,Azure AI Content Safety 可以通過 API 請求幫助檢測有害內容和圖像。

知識檢查

確保負責任的 AI 使用需要注意哪些事項?

- 這個答案是正確的。

- 有害使用,確保 AI 不被用於犯罪目的。

- 確保 AI 沒有偏見和歧視。

A: 2 和 3 是正確的。負責任的 AI 幫助您考慮如何減輕有害影響和偏見等。

🚀 挑戰

閱讀 Azure AI Content Saftey 並查看您可以採用的內容。

很棒的工作,繼續學習

完成本課程後,請查看我們的生成式 AI 學習集合以繼續提升您的生成式 AI 知識!

前往第4課,我們將查看提示工程基礎!